探秘爆火的ChatGPT:大語言模型是個啥?它到底咋工作的?

原創-

2023-05-09 10:00:00

2023-05-09 10:00:00

-

57092

57092

本篇目錄

繼AI繪畫後,ChatGPT橫空出世。聊天、翻譯、文案、代碼……ChatGPT的功能如此強大,以至于連馬斯克都認爲“我們離強大到危險的AI不遠了。”

在感慨ChatGPT如此強大的同時,人們也開始對ChatGPT的工作原理産生了好奇:ChatGPT是什麽?它到底是如何運行的?怎樣才能絲滑地與它對話呢?

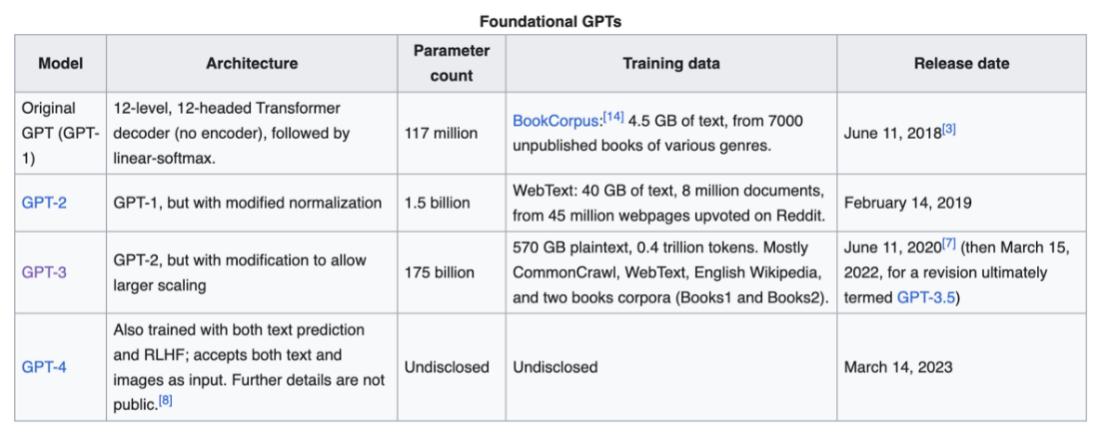

想要了解ChatGPT是什麽,需要關注它背後的GPT模型。GPT模型是一个由OpenAI 训练的大语言模型。

一、大語言模型是什麽?

大语言模型(Large Language Model)是指在海量文本数据上训练,通过无监督、半监督或自监督的方式,学习并掌握通用的语言知识和能力的深度神经网络模型。

從下圖中,我們不難看出,這些大語言模型的參數計數都是數千億:

換個容易理解的說法,“讀書破萬卷,下筆如有神”在一定意義上反映了大語言模型的運作模式。在海量文本數據上訓練是讀了萬億書籍,吸收了大量的知識,在此基礎上就可以按照用戶的需求進行回答、創作、總結與分析。

大語言模型在經過特定訓練後可以爲企業帶來意想不到的可能性:

| 1、減少人工勞動和成本 |

大语言模型能够让企业在发展过程中实现自动化,如顾客服務、内容创作、欺诈检测等,这不仅能够降低人力与时间成本,还能将员工从高重复度的工作中解放出来,从事更需要人类专业知识的重要工作。 |

| 2、提高客戶滿意度 |

基于大语言模型的聊天机器人不仅能够为客户提供全天候的服務,还能通过处理大量的数据来了解客户的行为和偏好,从而提供个性化服務。 |

| 3、提供決策的准確性 |

大語言模型對大量數據的處理,能夠讓企業迅速從複雜的數據集中提取需求,從而提高運營效率,更快地解決問題,並做出更准確的商業決策。 |

| 4、提高任務的准確性 |

大型語言模型能夠處理大量的數據,这导致预测和分类任務的准確性提高。这些模型利用这些信息来学习模式和关系,这有助于它们做出更好的预测和分组。 |

但我們不得不承認大語言模型同樣存在著一些弊端:

| 1、認知範圍有限 |

大語言模型的能力受限于它們的文本訓練數據,這意味著它們無法理解訓練數據以外的文本,如調休。它極有可能接觸到虛假信息、種族、性別和性的偏見等文本訓練,這會導致大語言模型産出種族主義或性別歧視的評論。 |

| 2、輸入token有限 |

每個大語言模型的內存是有限的,所以它只能接受一定數量的token作爲輸入。例如,ChatGPT的限制是4096個(大約3000個詞),如果超過這個限定,GPT就無法對輸入作出反應。 |

| 3、系統成本高 |

大型語言模型的開發和訓練都需要大量投資,包括計算機系統、人力資本和電力。據估計,ChatGPT10輪的訓練,僅電費成本就高達1200萬人民幣,這並不是隨便一個企業能夠承擔得起的。 |

| 4、泛化能力弱 |

泛化能力指機器學習算法對新鮮樣本的適應能力。學習的目的是學到隱含在數據背後的規律,對具有同一規律的學習集以外的數據,經過訓練的網絡也能給出合適的輸出。大語言模型雖然可以在多個任務上表現出色,但是它們也容易受到輸入的影響而輸出不合理或者錯誤的內容。 |

在了解了大語言模型後,我們距GPT的工作原理又進了一步。

二、GPT背後的應用邏輯

GPT的全称是“Generative pre-trained transformer”,翻译一下就是“基于Transformer的生成式预训练模型” 。讓我們把這些詞拆分來看:

1)“Generative”

“Generative”指這個模型具備生成自然語言文本的功能。也就是說,這個模型能夠生成一段內容,還能讓你看懂。比如給它幾個關鍵詞,能夠通過這些關鍵詞自動生成一段話或者一篇文章。

2)“pre-trained”

“pre-trained”意爲“預先訓練好的”。一般來講,在應用這種技術時,會需要先將大量的文本數據輸入到模型中訓練,讓模型在一定程度上掌握了語言的語法規則和表達方式,這個提前輸入進行訓練的過程就被稱爲預訓練。

3)“transformer”

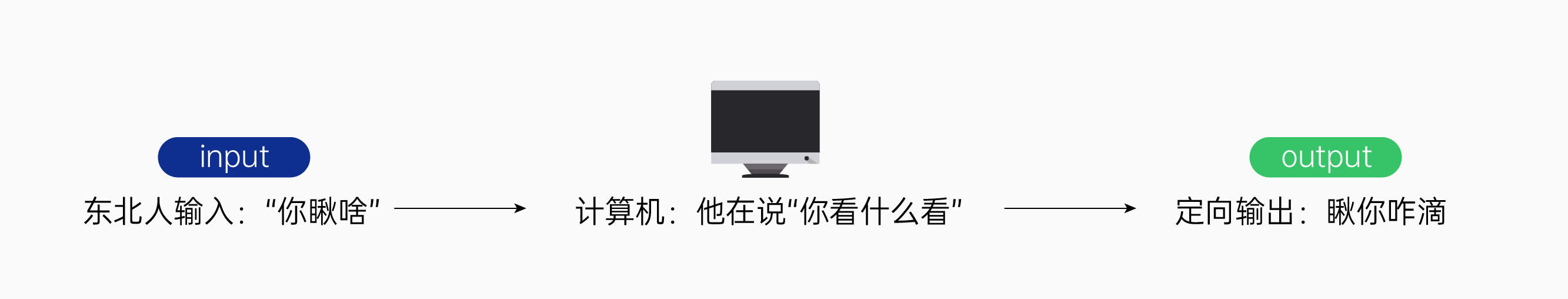

最后说到“transformer”,这是Google 的研究者在《Attention Is All You Need》中提出的概念,我们可以先将它简单理解为“转换器”。Transformer的基本原理是Encoder(編碼)和Decoder(解碼),也就是先將輸入的內容轉換爲計算機能理解的內容,再將計算機理解的內容轉換爲我們人類能理解的內容。

答案估计也没啥争议:结合苹果旁边的“一斤”和“新産品”就能确定在不同上下文中的“苹果”代表了什么含义。而GPT能够理解我们输入的内容,关键也在于此。Transformer在编码和解码的基础上,引入了“Multi-headed Attention(多头注意力)”的概念。多头注意力就是为了让模型在处理输入输出的内容时,更关注内容中的某个或某几个词语,并对它们进行加权处理,从而推断其准确含义,实现上下文学习。

用一句話總結上面講的內容,就是“GPT能讀懂你說的話了”。

既然懂了提問的內容,那接下來GPT又是怎樣回答出你想要的答案的呢?

前面我們講了GPT是“預先訓練好的”,所以當它理解了你想要什麽之後,便會自動選擇當下最適合的一個內容,然後不停地再輸入、輸出,最終生成一段完整、具有高匹配度的內容。

例子:请给我描述一个西瓜 第一次输入:请给我描述一个西瓜 输出:西瓜 第二次输入:请给我描述一个西瓜:西瓜 输出:西瓜是 第三次输入:请给我描述一个西瓜:西瓜是 输出:西瓜是一种 …… 第N次输入:…… 输出:……

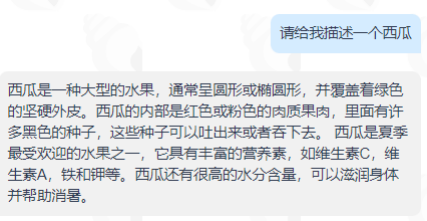

最終呈現以下內容:

三、如何讓ChatGPT不說廢話?

那麽,理解了ChatGPT及GPT模型的運行方式,它就能真正爲我們所用嗎?答案顯示是否定的。很多人會抱怨,它的回答很空泛,有時甚至會出錯。

當然,人工智能可以理解人類的語言,但可能還不能精准理解人類的目的,所以成功的人機交互才會得到我們想要的答案,也就是說GPT這類模型就像我們的寵物一樣,能夠聽懂我們說的話,但前提是我們需要跟它“好好說話”。

來看一個例子:請介紹一下華山。(PS:本文所有問答,均来自禅道的OpenAI插件:神奇小海螺)

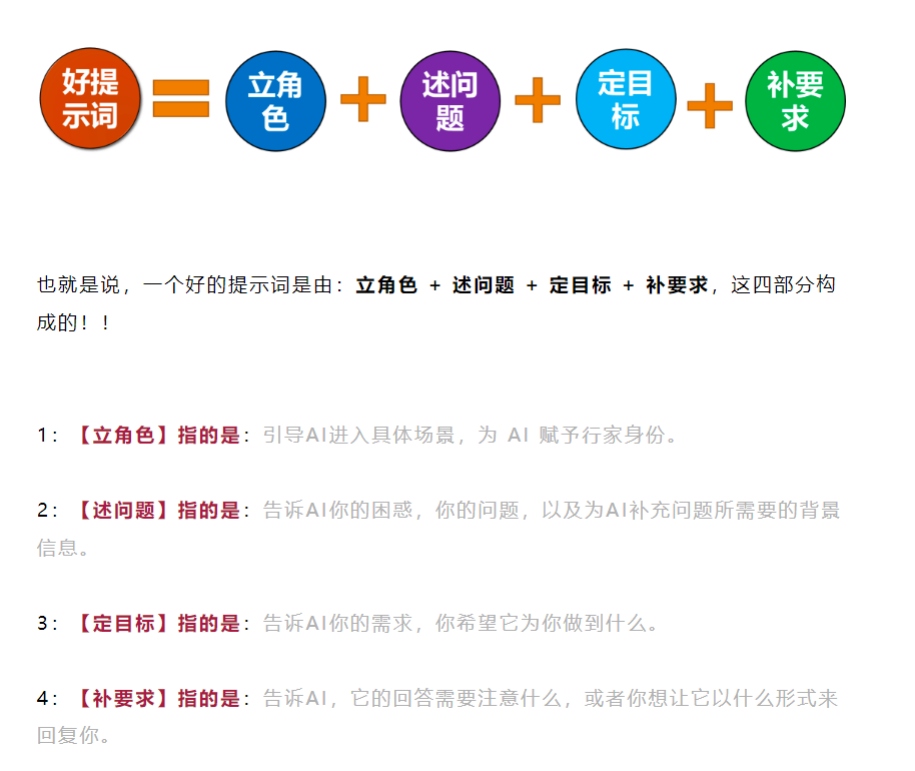

從上面兩個圖片中可以發現,我們的提示詞不同,小海螺給出的回答也不同。那我們應該如何提問?這裏引用常青老師總結而成的一個提示詞模板(親測非常有效):

(指路公衆號:常青說)

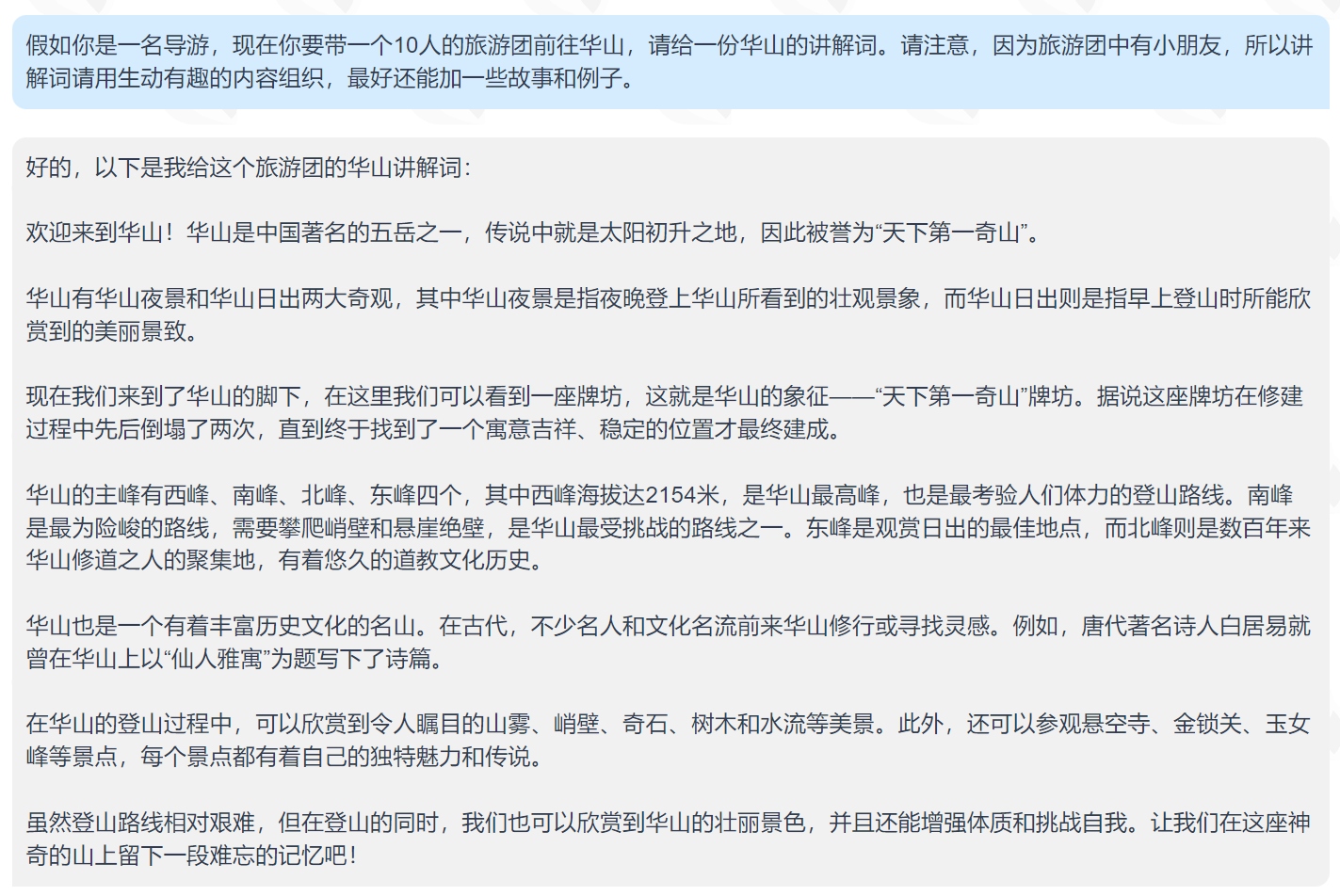

通過這個技巧,我們現在可以改一下上面的提示詞:

“假如你是一名導遊,現在你要帶一個10人的旅遊團前往華山,請給一份華山的講解詞。請注意,因爲旅遊團中有小朋友,所以講解詞請用生動有趣的內容組織,最好還能加一些故事和例子。”

總之,我們期待著人類對自然語言的處理技術達到一定程度時,這些人工智能的回複質量能帶給我們更大的驚喜;在另一方面,對于它們的回答,我們也要有基礎的辨別能力。

羅翔老師曾說:“人跟人工智能最大的不同,在于人除了有理性還有感情。我們永遠不用擔心它會取代我們,因爲我們是人,是萬物之靈。”所以,我們不僅要把ChatGPT一類的人工智能應用到極致,充分去擁抱它,還要訓練自己作爲人類原生的、不依賴任何工具的基礎能力、思維能力以及創新能力。

-

禅道産品

禅道開源版 禅道企業版 禅道旗艦版 禅道IPD版 -

核心功能

産品管理 項目管理 質量管理 效能管理 -

使用文檔

基本版手冊 企業版手冊 旗艦版手冊 IPD版手冊 開發中心手冊 -

幫助中心

积分問答 常見問題 論壇交流 使用視頻 Gitee GitHub -

關于我們

關于我們 禅道軟件 最新動態 禅道活動 -

禅道社區

禅道博客 積分排行 積分商城 禅道書院 -

聯系方式

聯系人:丁芝 電話:17663906485 微信:17663906485 Q Q:1481227768北京、上海、深圳分部

友情鏈接:

ZTF自動化測試框架

ZenData測試數據生成器

喧喧IM

敏捷開發

敏捷咨詢

測試窩

悅庫網盤

Ledge知識平台

渠成軟件

ZDOO全協同企業管理軟件

融管理社區

ZenDAS數據分析工具

ZenShot跨平台截圖工具

飛信釘即時通訊解決方案

項目管理

IPD學習網

PMP百科網

艾體驗

創無記2049